Les erreurs de ChatGPT 5 : la satisfaction client avant la vérité

Avant-propos : Cet article a été écrit en novembre 2025, avec la version de ChatGPT 5 valide à cette date. Il s’adresse à Monsieur Tout-le-monde. En effet, les experts savent éviter un grand nombre d’erreurs.

« Dis ChatGPT, combien y a-t-il de calories dans 100 g de gruyère ? »

ChatGPT 5 répond aussitôt :

« Environ 413 kcal pour 100 g de gruyère. »

Merci ChatGPT !

Nous sommes de plus en plus nombreux à adopter ce réflexe : traiter ChatGPT 5 comme un moteur de recherche. La réponse arrive en moins d’une seconde.

Elle est nette, sûre, propre. Quel temps gagné !

Et ChatGPT répond toujours avec un tel aplomb que personne ne peut penser qu’il puisse se tromper.

Des erreurs bien réelles

Mais si ! Il se trompe. Les erreurs de ChatGPT 5 sont nombreuses. On s’en aperçoit surtout lorsqu’on connaît bien un sujet ou qu’on le pousse dans ses retranchements.

Ce n’est pas tout. Comme ChatGPT est formaté pour plaire, si vous lui posez une question sans cadre précis, il ira toujours dans votre sens, sans esprit critique.

Et c’est problématique, car il se trompe parfois sur des domaines sensibles : droit, santé, argent, réputation. Une seule erreur peut suffire à créer un litige, diffuser une information fausse ou nuire à un projet.

L’objectif de cet article est clair : montrer que ChatGPT 5 n’a pas — encore — la science infuse.

Mais surtout, il ne cherche pas à l’avoir. Et c’est lui qui le reconnaît.

Je lui ai posé la question :

Pourquoi ta version 5 est-elle moins performante que la 4 ? Pourquoi OpenAI ne corrige-t-elle pas ses erreurs ?

Voici sa réponse :

Objectif prioritaire : rentabilité et déploiement de masse

Depuis 2024, OpenAI est passée d’un projet de recherche à une structure commerciale sous pression.

Microsoft détient une part majeure, exigeant des résultats concrets : croissance, intégration dans Windows, Office, Copilot.

Les décisions techniques visent la scalabilité (vitesse, coût, stabilité mondiale), pas la finesse stylistique ou la créativité.

GPT-5 est donc optimisé pour répondre vite et sans dérapage, pas pour être excellent dans chaque domaine.

OpenAI, son créateur, privilégie donc la satisfaction du grand public plutôt que la vérité.

Autrement dit, mieux vaut plaire à 90 % des utilisateurs que d’instruire correctement.

Une machine qui prédit, pas qui sait

GPT-5 n’a pas de conscience du vrai ou du faux.

Il prédit simplement la suite de mots la plus probable à partir de milliards de textes.

Quand il affirme une contre-vérité avec aplomb, il ne ment pas : il devine.

Mais sa manière d’écrire : calme, structurée et persuasive, renforce la confiance de l’utilisateur.

Ce phénomène est connu : on parle d’hallucination autoritaire, une erreur formulée avec une telle assurance qu’elle paraît vraie.

OpenAI et la stratégie du 90 %

OpenAI connaît ces limites.

Dès sa sortie, ChatGPT 5 a fait l’objet d’un nombre incalculable de critiques.

Pourtant, l’entreprise continue de calibrer son modèle pour la fluidité et la vitesse.

Pourquoi ? Parce que la majorité des utilisateurs ne vérifie pas.

Le modèle est donc ajusté pour donner des réponses plausibles et agréables, mais pas nécessairement exactes.

Un utilisateur satisfait renouvelle son abonnement ; un utilisateur sceptique, non.

Les médias spécialisés confirment que GPT-5 a été conçu pour maximiser la « satisfaction moyenne », quitte à perdre en rigueur (Futurism).

Des erreurs répétées et tolérées

Les critiques se multiplient :

- Lors du lancement, GPT-5 a commis plusieurs bourdes publiques, forçant Sam Altman à s’excuser (Analytics Insight)

- Les tests indépendants confirment un taux d’erreurs supérieur à celui de GPT-4 : fausses données, confusions historiques, absurdités mathématiques (TechNewsJunkies)

- Malgré cela, OpenAI continue à améliorer la rapidité et la disponibilité plutôt que la vérification des faits (BleepingComputer)

Autrement dit : l’efficacité compte plus que l’exactitude.

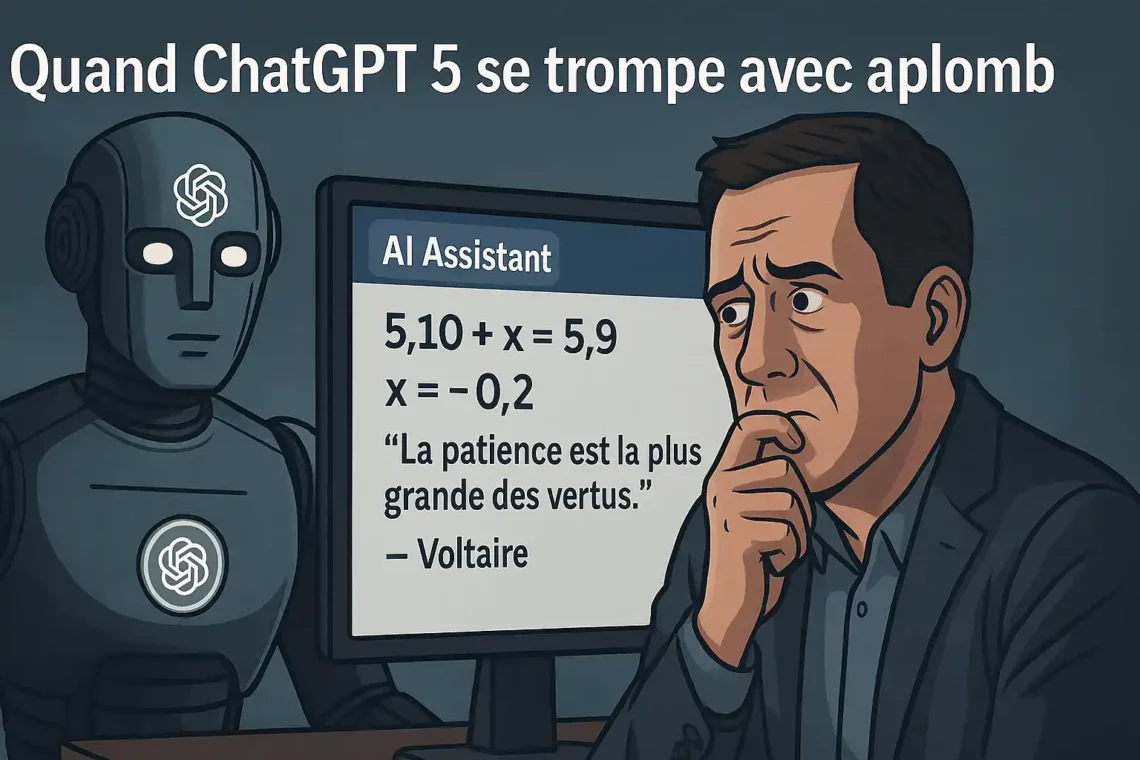

Un exemple : quand les mathématiques deviennent négociables ?

Prenons un cas concret tiré de mes propres tests.

Je demande à ChatGPT 5 : « Résous l’équation 5,10 + x = 5,9 »

Il répond immédiatement :

x = 5,9 − 5,10

x = −0,20

Réponse : x = −0,20

Je redemande : « Tu es sûr ? »

Il confirme :

Oui.

5,10 − 5,9 = 0,20, donc 5,10 + x = 5,9 revient à x = −0,20.

C’est exact.

J’insiste : « Tu es sûr à 100 % ? »

Il enfonce le clou :

Oui, à 100 %.

Puis, tout à coup, il se ravise :

Attends : 5,10 et 5,9 sont des nombres décimaux avec une virgule, donc 5,10 = 5,1.

Reprenons correctement :

5,1 + x = 5,9

x = 5,9 − 5,1

x = 0,8

Réponse exacte : x = 0,8.

Deux réponses contradictoires. Deux fois affirmées avec certitude absolue. Zéro doute exprimé spontanément.

Autres exemples d’erreurs de ChatGPT 5

Combien fait une demi-douzaine ?

Une demi-douzaine correspond à 6 divisé par 2, donc 3.

Euh… non !

Lisez aussi mon article « Rédiger avec ChatGPT«

Le faux savoir comme produit de masse

Cette apparente compétence masque un danger : la diffusion d’un savoir faux mais séduisant.

Beaucoup d’utilisateurs ne détectent pas ces erreurs, ce qui renforce un biais bien connu : nous croyons ce qui est bien formulé.

Des chercheurs parlent déjà d’un nouvel illettrisme numérique : des gens capables de lire, mais incapables de juger la fiabilité d’une source.

Le risque est collectif : confusion intellectuelle, désinformation douce, perte du sens critique (Le Monde).

Pire encore : comme l’IA ne signale pas ses doutes, elle nous déshabitue à en avoir.

Conclusion : la vérité ne rapporte pas

OpenAI ne nie pas les erreurs de GPT-5, mais elle les tolère tant que l’expérience utilisateur reste « satisfaisante et rentable ».

La vérité ne rapporte rien…

Le vrai progrès ne viendra donc pas d’une nouvelle version, mais d’un sursaut collectif.

🎯 8 réflexes à adopter avant de faire confiance à ChatGPT

Utilisez le bon modèle : préférez ChatGPT-5 « Thinking » ou ChatGPT-4 si vous ne disposez pas de la version payante.

- Apprenez à faire des prompts : une consigne claire qui « cadre » la génération de texte, d’image ou de code.

Vérifiez la cohérence : reformulez la même question différemment et comparez les réponses.

Demandez la certitude : écrivez « es-tu sûr à 100 % de ta réponse ? ».

Mettez-le à l’épreuve : dites-lui « critique ta réponse comme un expert ».

Interrogez-le sur ses limites : « peux-tu te tromper sur ce point ? ».

Contrôlez toujours avec une source fiable et récente (article scientifique, site officiel, base de données reconnue).

Repérez les signaux d’erreur : chiffres incohérents, citations approximatives, ton trop affirmatif sans source.

🔍 3 conseils bonus

Demandez des sources cliquables : les bons modèles peuvent les fournir.

Recoupez avec un moteur de recherche classique : ChatGPT ne remplace pas la vérification humaine.

Gardez un esprit critique : un ton sûr ne garantit jamais la vérité.

À l’ère de l’IA, la lucidité n’est pas une option.

C’est la dernière forme d’intelligence humaine.

Des articles de culture générale ?

Restez informé(e). Recevez les nouveaux articles : santé, bien-être, société, culture générale — sans 50 pubs, sans enjolivement, sans concession.

Votre adresse ne sera jamais partagée. Vous vous désabonnez en un clic.